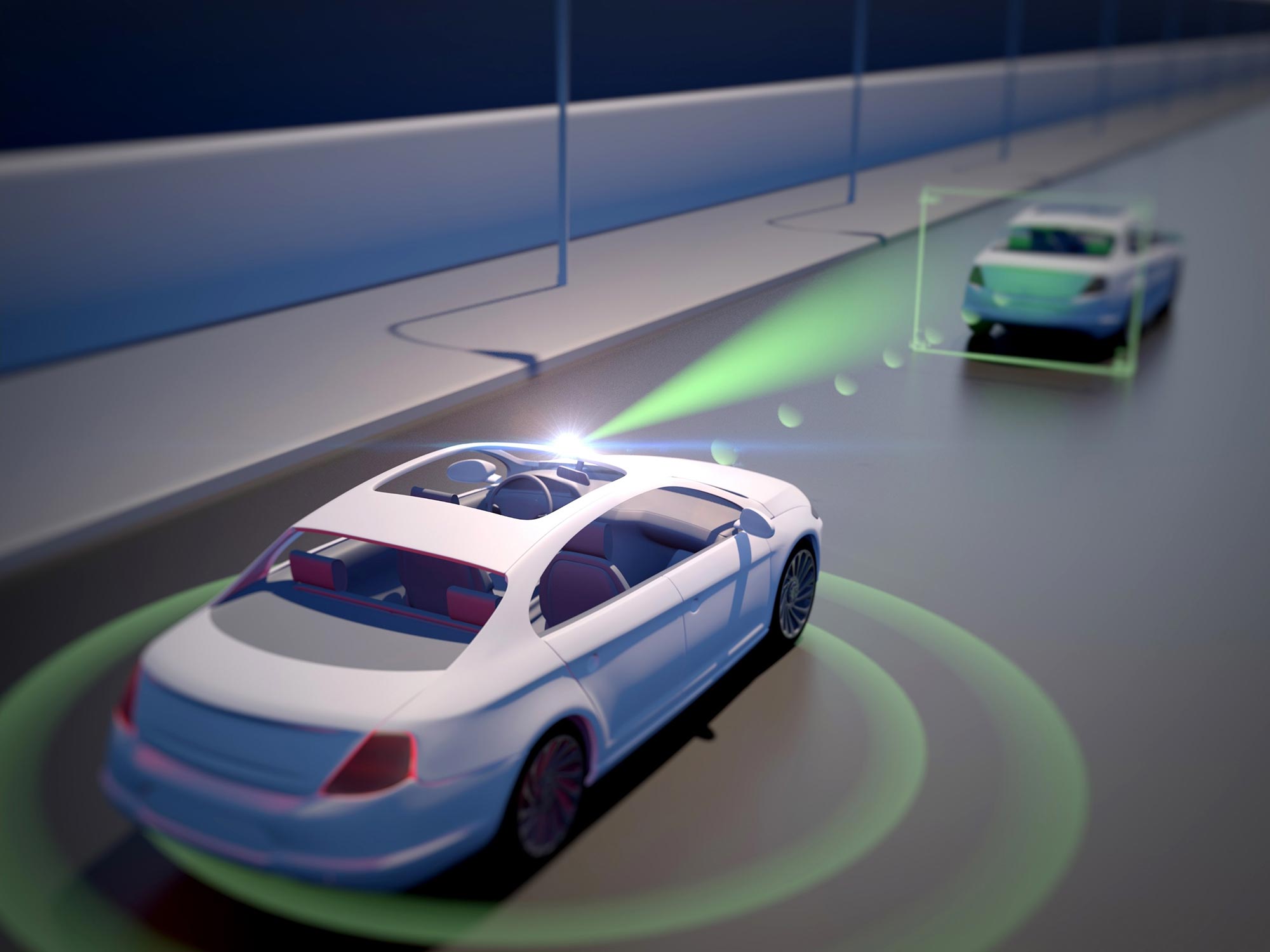

VISTA 2.0 is an open-source simulation engine that can make realistic environments for training and testing self-driving cars. Credit: Image courtesy of MIT CSAIL

With this in mind, scientists from MIT’s Computer Science and Artificial Intelligence Laboratory (CSAIL) created “VISTA 2.0,” a data-driven simulation engine where vehicles can learn to drive in the real world and recover from near-crash scenarios. What’s more, all of the code is being released open-source to the public.

“Today, only companies have software like the type of simulation environments and capabilities of VISTA 2.0, and this software is proprietary. With this release, the research community will have access to a powerful new tool for accelerating the research and development of adaptive robust control for autonomous driving,” says the senior author of a paper about the research, MIT Professor and CSAIL Director Daniela Rus.

VISTA es un simulador fotorrealista basado en datos para la conducción autónoma. Puede simular no solo video en vivo, sino también datos LiDAR y cámaras de eventos, y también incorporar otros vehículos simulados para modelar situaciones de conducción complejas. VISTA es de código abierto y el código se puede encontrar a continuación.

VISTA 2.0, que se basa en el modelo anterior del equipo, VISTA, es fundamentalmente diferente de los simuladores AV existentes porque se basa en datos. Esto significa que fue construido y renderizado de forma fotorrealista a partir de datos del mundo real, lo que permite una transferencia directa a la realidad. Si bien la iteración inicial solo admitía el seguimiento de un solo carril de automóvil con un solo sensor de cámara, lograr una simulación basada en datos de alta fidelidad requería repensar los fundamentos de cómo se pueden sintetizar diferentes sensores e interacciones de comportamiento.

Ingrese a VISTA 2.0: un sistema basado en datos que puede simular tipos de sensores complejos y escenarios e intersecciones masivamente interactivos a gran escala. Usando muchos menos datos que los modelos anteriores, el equipo pudo entrenar vehículos autónomos que podrían ser significativamente más robustos que los entrenados con grandes cantidades de datos del mundo real.

“Este es un gran salto en las capacidades de simulación basadas en datos para vehículos autónomos, así como un aumento en la escala y la capacidad de manejar una mayor complejidad de conducción”, dice Alexander Amini, estudiante de doctorado de CSAIL y coautor principal de dos nuevos artículos. , con su compañero estudiante de doctorado Tsun-Hsuan Wang. “VISTA 2.0 demuestra la capacidad de simular datos de sensores mucho más allá de las cámaras 2D RGB, pero también lidars 3D extremadamente dimensionales con millones de puntos, cámaras basadas en eventos cronometrados irregularmente e incluso escenarios interactivos y dinámicos con otros vehículos también”.

El equipo de científicos pudo adaptar la complejidad de las tareas de conducción interactiva para cosas como adelantar, seguir y negociar, incluidos escenarios de múltiples agentes en entornos altamente fotorrealistas.

Debido a que la mayoría de nuestros datos (afortunadamente) solo se refieren a la conducción común y cotidiana, el entrenamiento de modelos de IA para vehículos autónomos implica un forraje difícil de asegurar de diferentes variedades de casos extremos y escenarios extraños y peligrosos. Lógicamente, no podemos simplemente chocar contra otros autos solo para enseñarle a una red neuronal cómo no chocar contra otros autos.

Recientemente, ha habido un alejamiento de los entornos de simulación más clásicos diseñados por humanos hacia aquellos creados a partir de datos del mundo real. Estos últimos tienen un fotorrealismo inmenso, pero los primeros pueden modelar fácilmente cámaras virtuales y lidars. Con este cambio de paradigma, ha surgido una pregunta clave: ¿podemos sintetizar con precisión la riqueza y complejidad de todos los sensores que necesitan los vehículos autónomos, como los lidar y las cámaras de eventos, que son más raros?

Los datos de los sensores Lidar son mucho más difíciles de interpretar en un mundo basado en datos: básicamente está tratando de generar nuevas nubes de puntos 3D con millones de puntos, solo a partir de vistas dispersas del mundo. Para sintetizar las nubes de puntos lidar 3D, los investigadores utilizaron los datos recopilados por el automóvil, los proyectaron en el espacio 3D a partir de los datos lidar y luego dejaron que un nuevo vehículo virtual se moviera localmente desde la ubicación donde se encontraba el vehículo original. Finalmente, proyectaron toda esta información sensorial en el marco de visión de este nuevo vehículo virtual, utilizando redes neuronales.

Junto con la simulación de cámaras basadas en eventos, que operan a velocidades superiores a miles de eventos por segundo, el simulador no solo pudo simular esta información multimodal, sino también hacerlo en tiempo real. Esto hace posible entrenar redes neuronales fuera de línea, pero también realizar pruebas en línea en el automóvil en configuraciones de realidad aumentada para evaluaciones seguras. “Si la simulación multisensor a esta escala de complejidad y fotorrealismo era posible en el ámbito de la simulación basada en datos era una pregunta abierta”, dice Amini.

Con esto, la autoescuela se convierte en una fiesta. En la simulación, puede moverse, tener diferentes tipos de controladores, simular diferentes tipos de eventos, crear escenarios interactivos y simplemente colocar nuevos vehículos que ni siquiera estaban en los datos originales. Probaron el seguimiento de carril, el cambio de carril, el seguimiento de automóviles y escenarios más riesgosos como adelantamientos estáticos y dinámicos (ver obstáculos y moverse para evitar chocar). Con la multiagencia, los agentes reales y simulados interactúan, y se pueden colocar nuevos agentes en la escena y controlarlos de cualquier manera.

Al llevar su automóvil de tamaño completo al “desierto”, también conocido como Devens, Massachusetts, el equipo vio la transferencia inmediata de los resultados, tanto con fallas como con éxitos. También pudieron demostrar la palabra mágica y audaz de los modelos de coches autónomos: “robustos”. Demostraron que los AV, completamente entrenados en VISTA 2.0, eran tan robustos en el mundo real que podían manejar esa elusiva cadena de fallas difíciles.

Ahora, una barrera de seguridad en la que confían los humanos y que aún no se puede simular es la emoción humana. Es el saludo amistoso, el asentimiento o el interruptor parpadeante de reconocimiento, que son el tipo de matices que el equipo quiere implementar en el trabajo futuro.

“El algoritmo central de esta investigación es cómo podemos tomar un conjunto de datos y construir un mundo completamente sintético para el aprendizaje y la autonomía”, dice Amini. “Es una plataforma que creo que algún día podría expandirse en muchos ejes diferentes a través de la robótica. No solo la conducción autónoma, sino muchas áreas que dependen de la visión y comportamientos complejos. Estamos emocionados de lanzar VISTA 2.0 para permitir que la comunidad recopile sus propios conjuntos de datos y los convierta en mundos virtuales donde pueden simular directamente sus propios vehículos autónomos virtuales, conducir en estos terrenos virtuales, entrenar vehículos autónomos en estos mundos y luego transferirlos. directamente a coches autónomos reales de tamaño completo.

Referencia: “VISTA 2.0: un simulador abierto basado en datos para detección multimodal y aprendizaje de políticas para vehículos autónomos” por Alexander Amini, Tsun-Hsuan Wang, Igor Gilitschenski, Wilko Schwarting, Zhijian Liu, Song Han, Sertac Karaman y Daniela Rus, 23 de noviembre de 2021, TI > Robótica.

arXiv:2111.12083

Amini y Wang escribieron el artículo junto con Zhijian Liu, estudiante de doctorado en MIT CSAIL; Igor Gilitschenski, profesor asistente de informática en la Universidad de Toronto; Wilko Schwarting, investigador de IA y MIT CSAIL PhD ’20; Song Han, profesor asociado del Departamento de Ingeniería Eléctrica y Ciencias de la Computación del MIT; Sertac Karaman, profesor asociado de aeronáutica y astronáutica en el MIT; y Daniela Rus, profesora del MIT y directora de CSAIL. Los investigadores presentaron su trabajo en la Conferencia Internacional IEEE sobre Robótica y Automatización (ICRA) en Filadelfia.

Este trabajo fue apoyado por la Fundación Nacional de Ciencias y el Instituto de Investigación de Toyota. El equipo agradece el apoyo de NVIDIA con la donación de Drive AGX Pegasus.

![]()